Google科学家近日发布了一项令人振奋的研究成果,他们在正常的AI模型研究中,无意中发现了一个引人注目的现象:经过持续训练,即便是简单的AI模型也能逐渐摆脱死记硬背的状态,获得了令人惊叹的“领悟力”(grokking),展现出对未见数据的泛化能力。

这一现象揭示了AI掌握泛化能力的关键,这对于人工智能领域具有重大意义。专为此成果,科学家撰写了一篇详尽的博客,深入探讨了这一现象的原理,并承诺将继续研究,以揭示大模型突然获得强大理解力的真正原因。

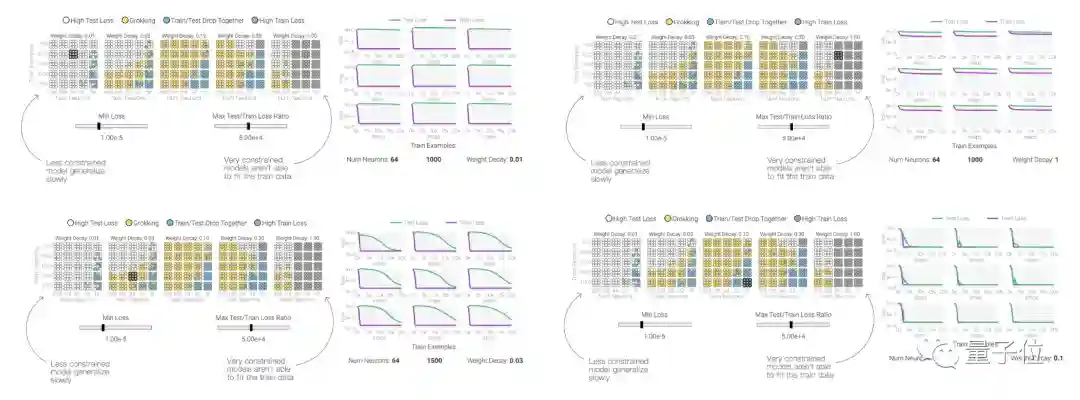

首先,科学家们分析了“领悟力”现象的两个关键发现:一是,尽管训练过程中损失(loss)会突然下降,但“领悟力”并非突然出现,而是一个逐渐平滑变化的过程;二是,并非所有的AI模型都能够获得“领悟力”。

他们通过一个“数奇数”任务的示例解释了这一现象,展示了模型从最初的混乱状态逐渐进化到“领悟”状态的过程。此过程旨在最小化损失,采用了权重衰减技术来防止过拟合。

同时,科学家们还进行了多次训练实验,发现只有一部分AI模型能够真正获得“领悟力”。仔细调整了超参数,他们成功区分出两类模型,其中只有一类具备了“领悟力”。这些发现揭示了参数量、权重衰减、模型大小和数据量等因素对“领悟力”产生重要影响。

通过设计更大的模型,科学家们进一步深入探讨了AI模型学会泛化的机制。他们运用了不同规模的模型进行“模加法”任务的训练,展示了神经元权重随着输入出现周期性变化的关键现象。这种变化意味着AI模型能够自主学习数学结构,从而实现从死记硬背到具备泛化能力的转变。

这项研究不仅揭示了AI模型学会“领悟”的机制,还为进一步探索更大模型的泛化能力提供了思路。此外,这一成果也有望帮助自动发现神经网络学习算法,推动AI自我设计的领域发展。

最后,值得一提的是,这一研究成果由Google的People + AI Research(PAIR)团队共同完成。PAIR团队致力于通过跨学科研究和构建工具,推动AI在公平性、可靠性等方面的发展,旨在让AI更好地造福于人类。

作品采用:

《

署名-非商业性使用-相同方式共享 4.0 国际 (CC BY-NC-SA 4.0)

》许可协议授权