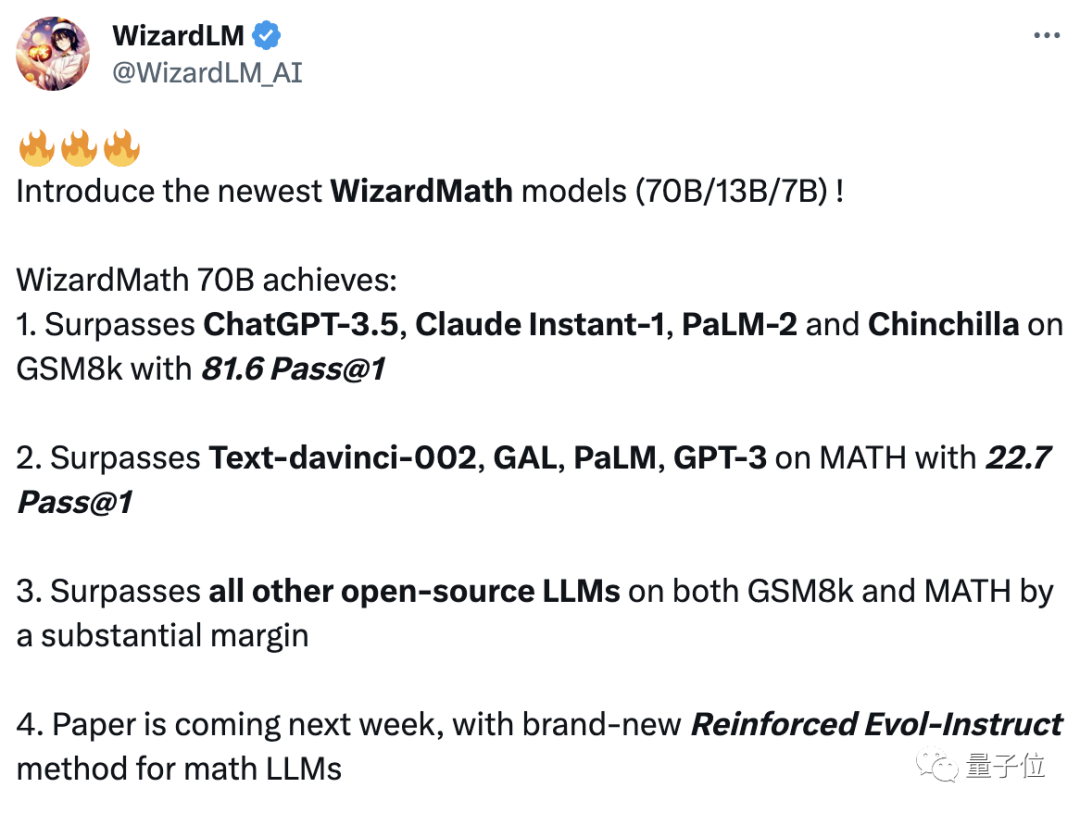

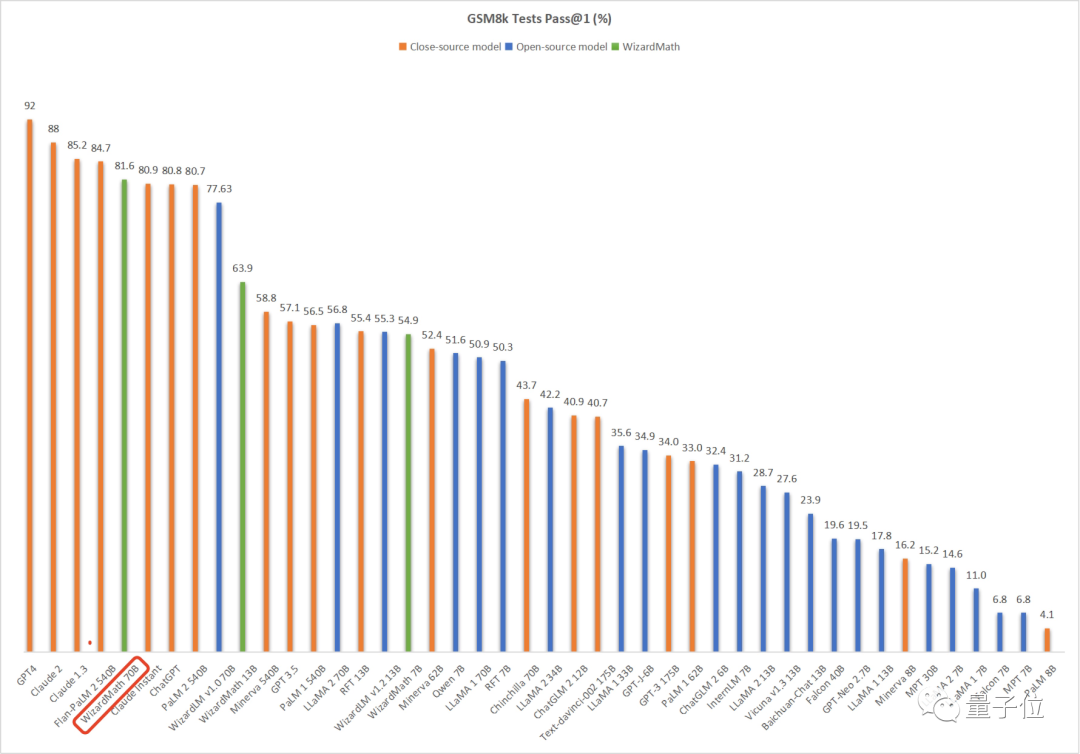

微软最新开源大模型WizardMath正式登场,通过AI生成的指令微调,数学能力直逼ChatGPT 70B。在经过GSM8k数据集的严格测试后,WizardMath不仅在参数规模上远不及其他大模型,更在数学能力上展现出耀眼光芒。

【图】

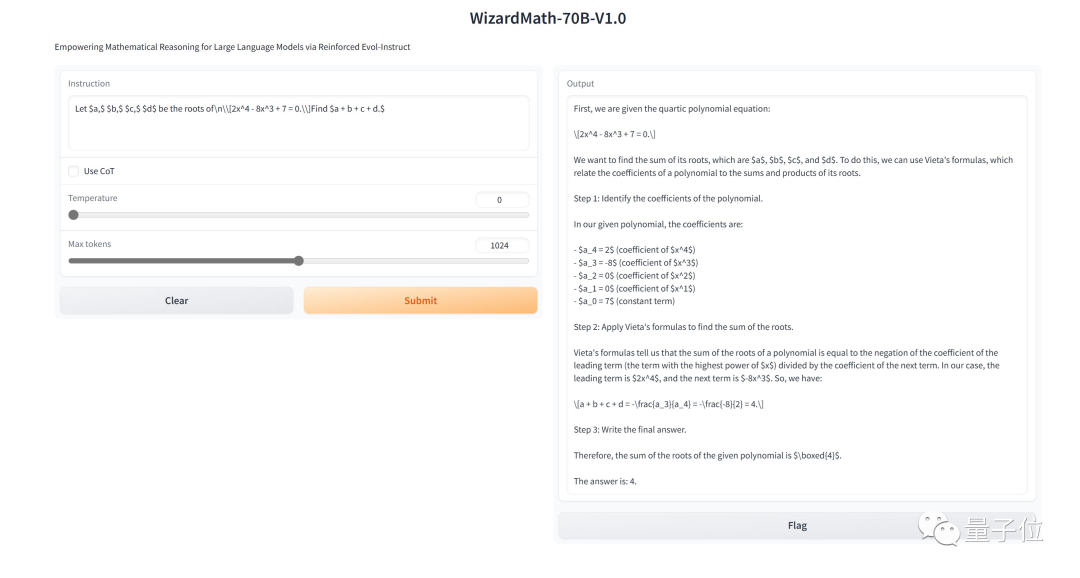

HuggingFace近期上线了WizardMath的三个在线可玩版本(7B、13B和70B参数),你可以直接将各种数学题丢进模型中,例如解决复杂的多项式方程、微积分问题,甚至是推导修改过的拉格朗日方程。惊人的是,这些问题的解答不仅正确,而且计算速度也令人惊叹。

许多网友纷纷表示,WizardMath的效果真是令人惊叹,对于开源LLM的贡献表示感谢。

不仅如此,WizardMath的开源代码、复现方式以及相关论文已经在GitHub上线,并在短短几天内获得了超过4.8k的标星。

那么,WizardMath是如何实现这一非凡的数学能力的呢?

突破:用AI生成的指令增强大模型能力

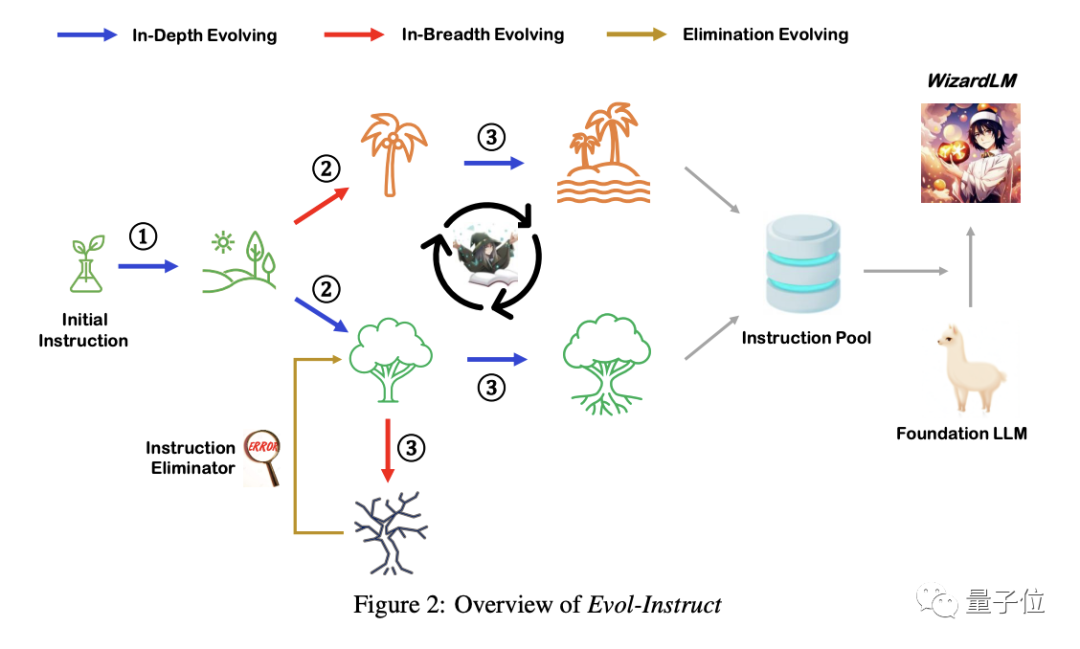

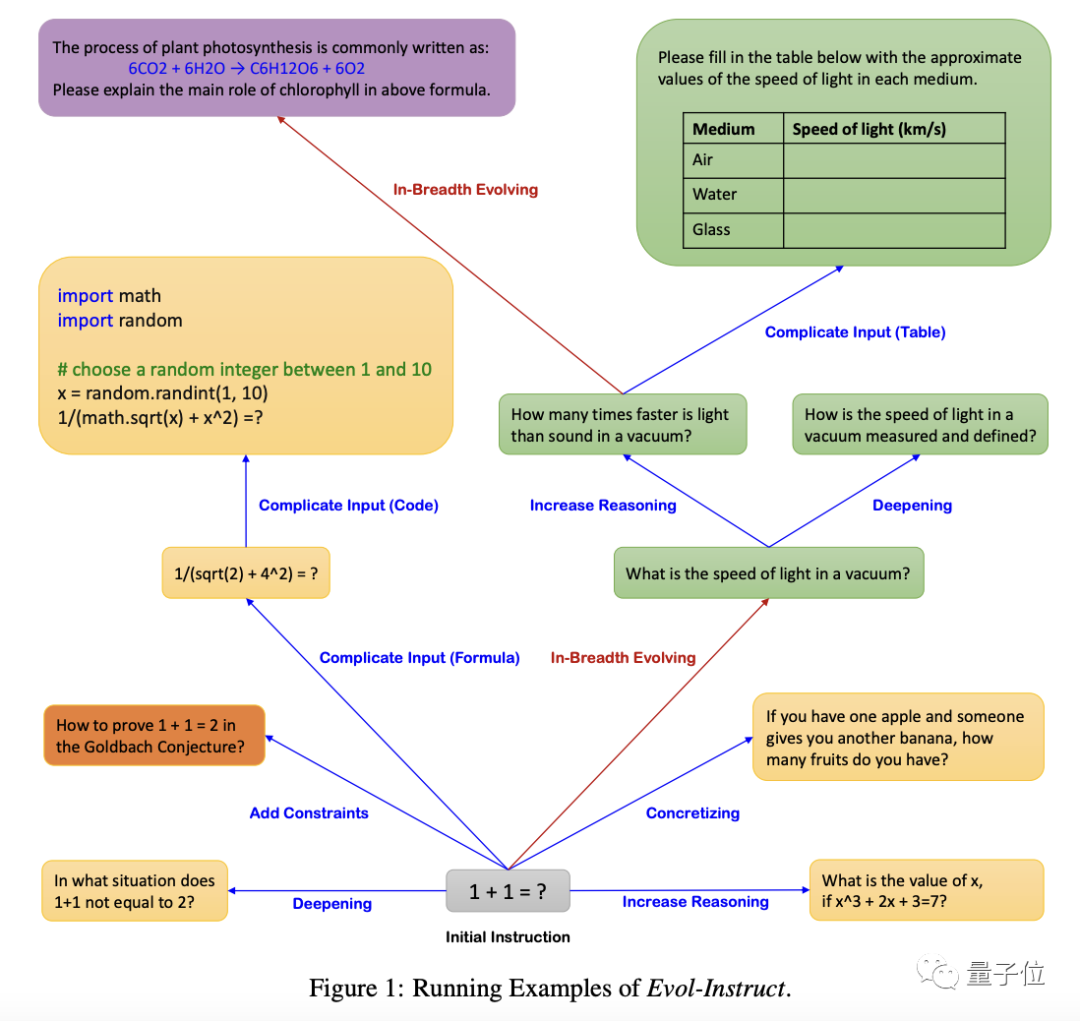

在AI领域,大模型如InstructGPT和GPT-4等通过微调真实人类生成的开放域指令数据,取得了惊人的成功。然而,这种指令数据集的获取成本高昂且耗时,限制了许多人的使用。微软团队创新性地提出了Evol Instruction方法,利用AI自动生成各种难度级别的开放域指令,为大模型的提升注入新的能量。

Evol Instruction方法包括指令进化器和指令消除器。指令进化器通过深度进化和广度进化等方法,将简单指令升级为复杂的指令,甚至生成全新的指令。这一过程在一定程度上模拟了生物进化的原理。

通过重复生成和进化,微软团队获得了足够多的指令,随后将其合并并打乱,形成了均衡分布的指令集。这些指令被用来微调基础大模型,从而达到了超越其他模型的数学能力。

WizardMath的崭露头角

微软团队在Alpaca训练数据的基础上,经过多个进化周期,获得了25万条指令。通过对比测试,WizardLM在复杂指令处理上明显领先于其他模型,表现出更高的性能。

这一方法还为WizardMath的诞生铺平了道路。WizardMath在GSM8k数据集上脱颖而出,超越了ChatGPT、Claude Instant 1、PaLM 2-540B等多个大模型,在数学领域排名第5,仅次于GPT-4、Claud1.3和2.0,以及拥有5400亿参数的Flan-PaLM 2。

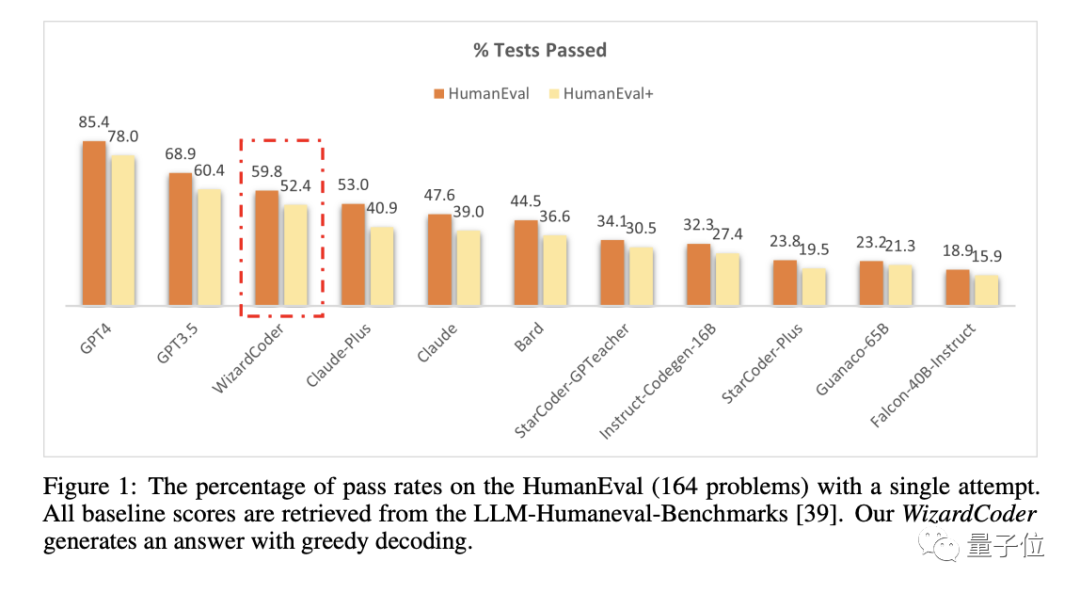

同时,WizardMath的成功也引发了更多的探索。微软团队不仅开发了专攻代码能力的WizardCoder,还通过Evol Instruction方法在不同领域获得了令人瞩目的成果。

【团队介绍】

这篇突破性论文由9位全华人作者合作完成。其中,Can Xu、Qingfeng Sun和Kai Zheng是一作,他们在微软亚洲互联网工程院以及微软研究部门从事自然语言处理等工作。通讯作者姜大昕曾在微软担任重要职务,并投身大模型领域的创业。

在微软团队的不懈努力下,WizardMath以其强大的数学能力引领着大模型的未来,为人工智能领域带来了新的可能性。详细内容可访问项目主页:https://github.com/nlpxucan/WizardLM/tree/main/WizardMath。

作品采用:

《

署名-非商业性使用-相同方式共享 4.0 国际 (CC BY-NC-SA 4.0)

》许可协议授权